oldcatY·2 years ago

为什么搭建DeepLX

现在市面上可选的翻译软件多种多样,传统的翻译软件有网易的有道翻译、字节跳动的火山翻译、谷歌的谷歌翻译、微软的Bing翻译等……基于LLM大模型的翻译可以调用Gemini、OpenAI等的API进行翻译,那么为什么要选择DeepL呢?

-

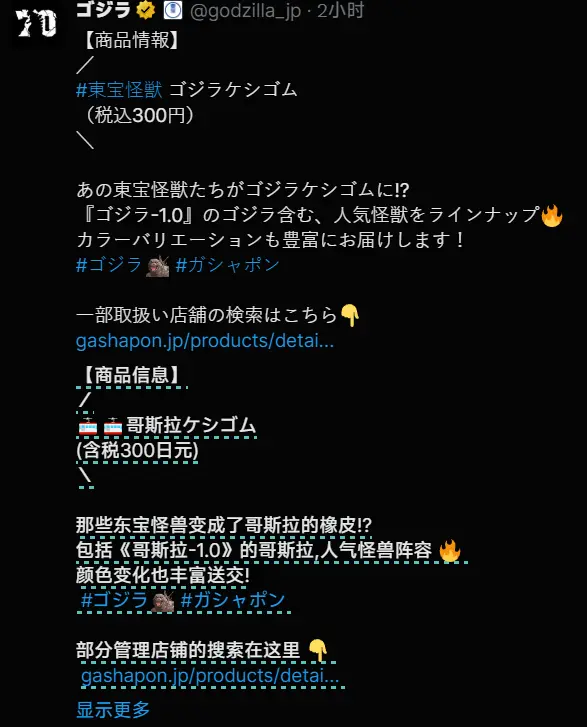

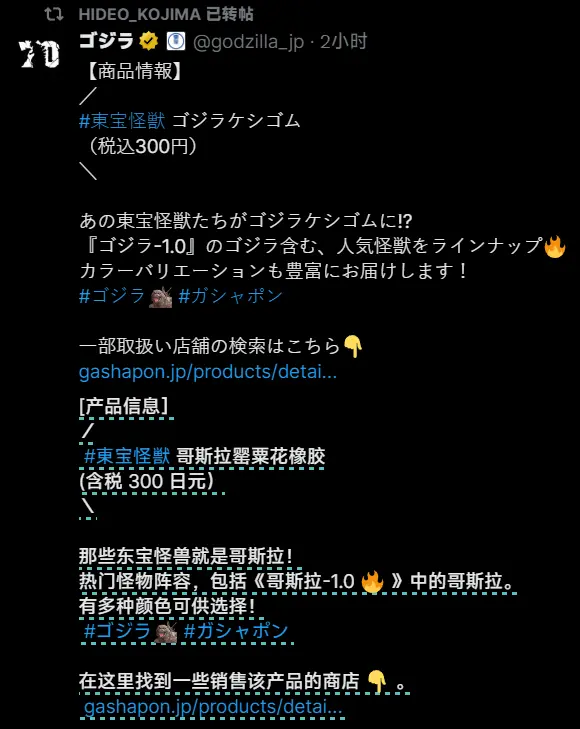

快速且准确的翻译(对比传统翻译器)

在我使用有道等进行翻译时,最常遇到的问题就是翻译准度不高(尤以非英文 to 中文翻译为甚),且通常存在漏翻问题(如碰到较为口语化的表达时)

那么DeepL作为最先使用AI进行翻译模型训练的翻译器,自然相较于通用翻译会更加准确

-

翻译速度较快,且基本不受并发数限制(对比LLM大模型翻译)

基于Gemini、OpenAI的翻译固然准确,可是其受限于API调用次数,不能在并发数较高的环境下完成翻译(如使用沉浸式翻译插件自动翻译推特)。相比之下,DeepL可以在保证一定的翻译准度的前提下,拥有不输传统翻译器的翻译速度。

然而其官方DeepL由于自身速度较慢,且有额度限制,不提供API等等缺点,容易劝退很多用户,DeepLX 在 GitHub开源,不限制请求次数(但 DeepL 可能会限制 IP)默认情况下监听本地 1188 端口。提供多种安装方式。

如何搭建DeepLX

感谢原作者 OwO-Network 的辛勤付出

一键安装

bash <(curl -Ls https://raw.githubusercontent.com/OwO-Network/DeepLX/main/install.sh)

或者

bash <(curl -Ls https://owo.nz/deeplx)

放行1188端口

这一步在你的VPS服务商后台完成,各服务商放行方式不同,请自行搜索

测试

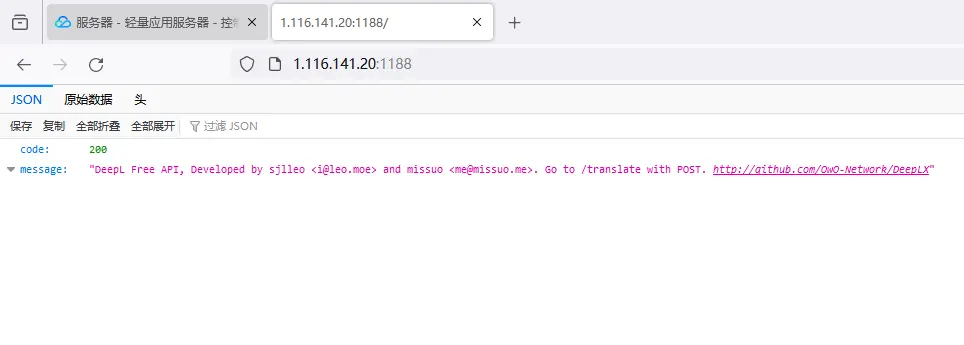

访问 ip:1188 来进行测试,若返回 code: 200 ok 则表示搭建成功

在翻译插件里使用(以沉浸式翻译为例)

-

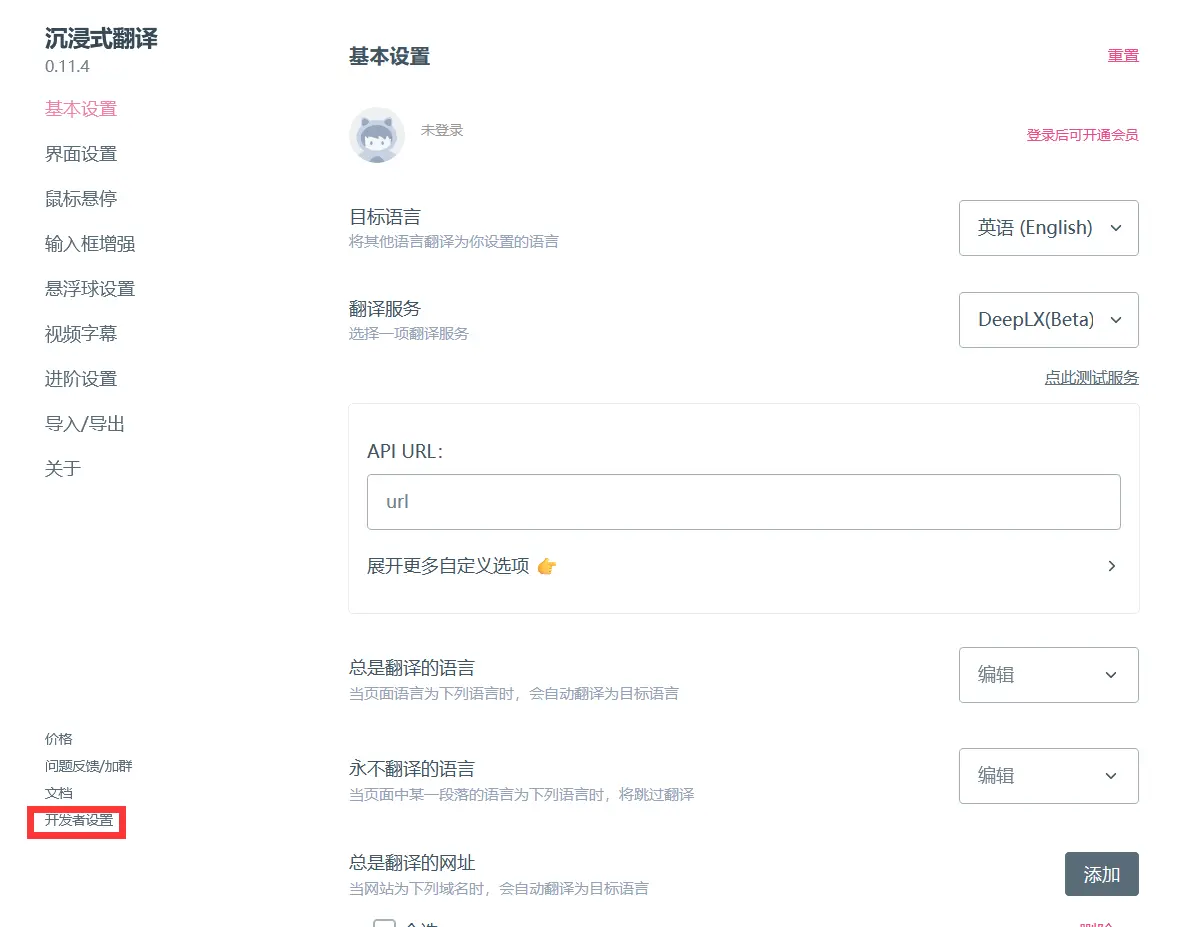

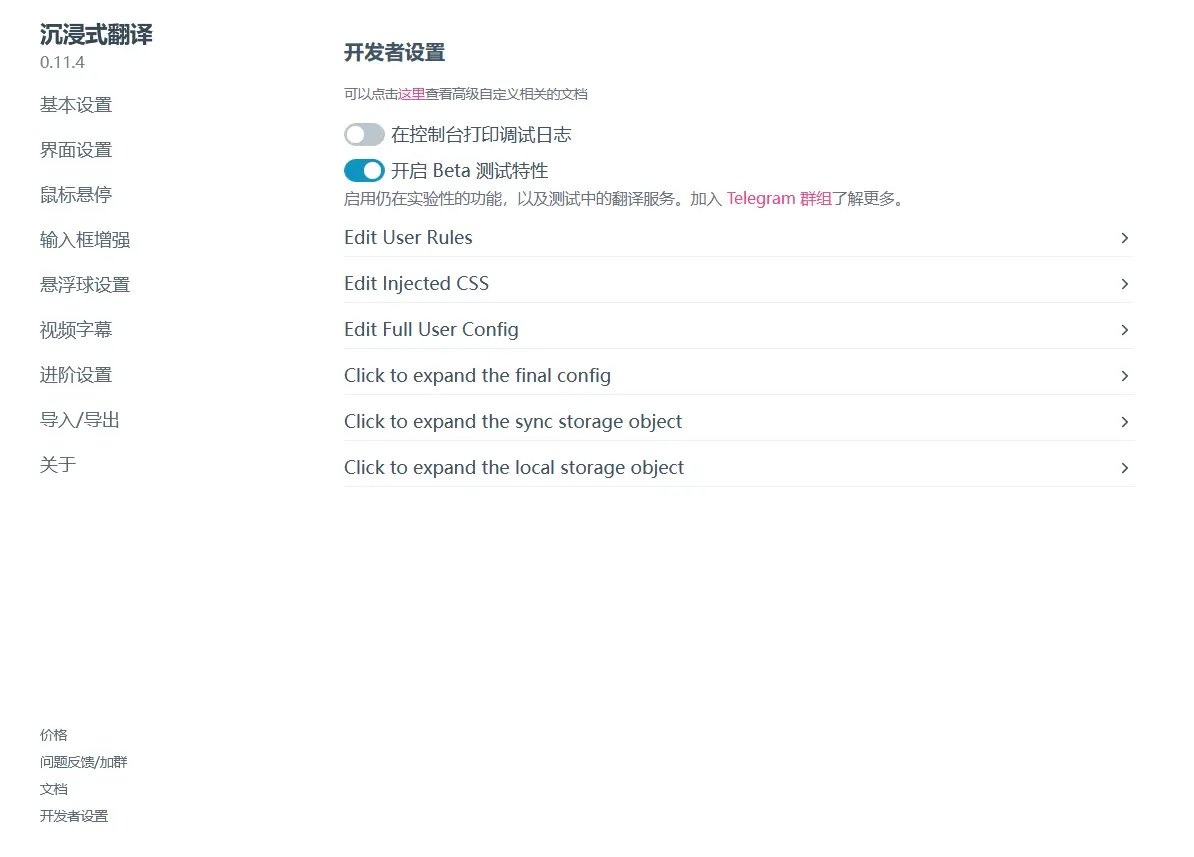

在沉浸式翻译的插件设置中,点击 开发者设置 ,并开启Beta测试特性

-

然后回到基础设置,翻译服务选择DeepLX(Beta),URL中填入自己搭建的服务URL,也就是

[ip]:1188/translate

鸣谢

Drag and drop your files here

Loading comments...

Source